Jak działa proces testowania A/B?

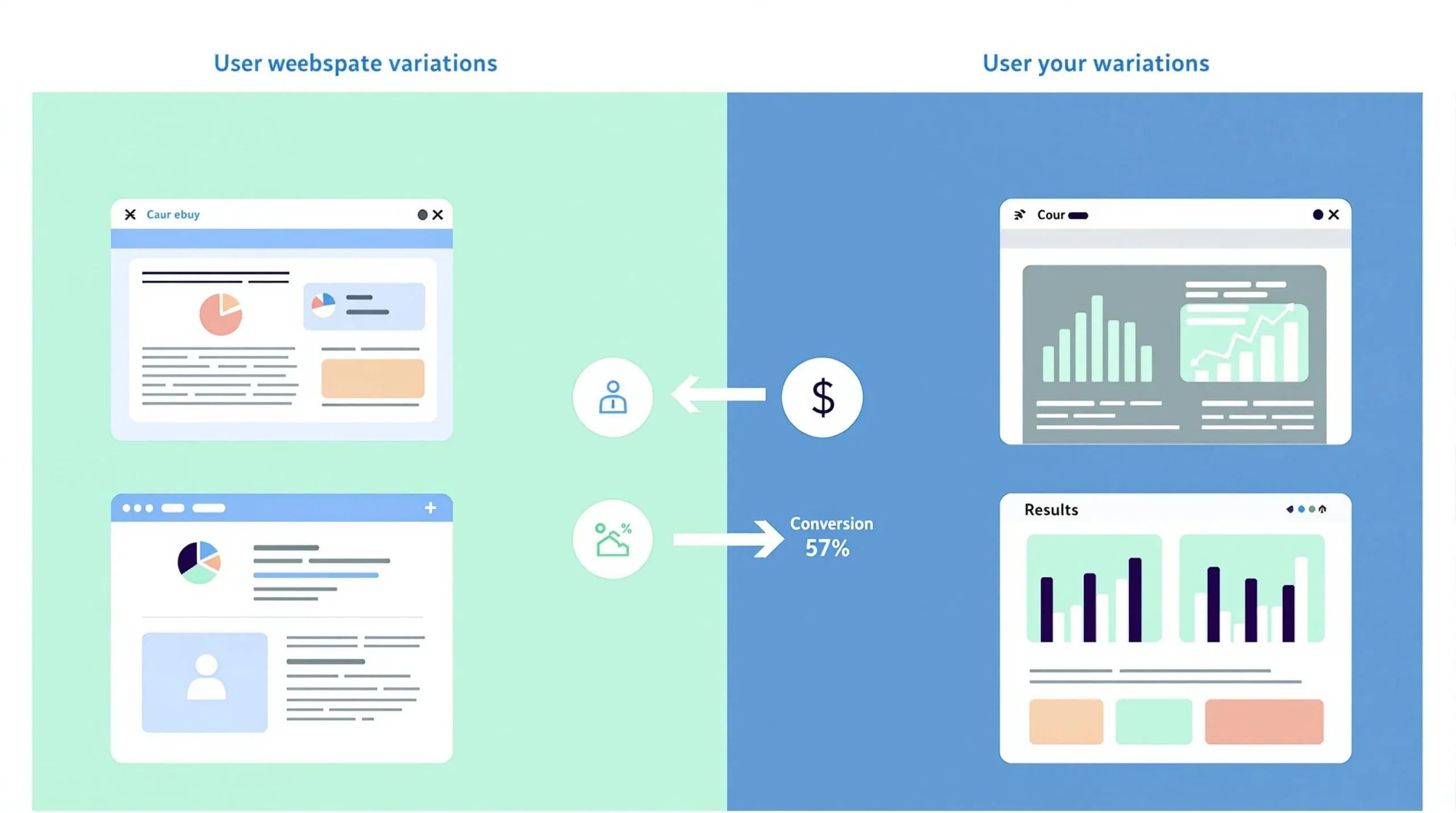

Zastanawiałeś się kiedyś, co tak naprawdę kryje się za całym tym zgiełkiem wokół testów A/B? To nic innego jak pojedynek dwóch wersji – strony, reklamy czy wiadomości – które walczą o to, która zyska większe uznanie, mierzone choćby liczbą kliknięć lub czasem, jaki użytkownicy spędzają na stronie. To próba zmierzenia, co działa lepiej, bez wróżenia z fusów.

Proces zaczyna się od zebrania danych – trochę jak zbieranie tropów przed rozpoczęciem śledztwa. Sprawdzamy, jak obecna wersja radzi sobie na polu bitwy, by wiedzieć, od czego startujemy. Potem nadchodzi czas eksperymentu: tworzymy wariant B, czyli coś na kształt bliźniaka z drobnymi różnicami, które mogą zmienić grę. Następnie ruch użytkowników jest dzielony między obie wersje niczym karty rozdawane w pokera – losowo i równomiernie, by nikt nie miał przewagi.

Kiedy test dobiega końca, nadchodzi moment prawdy – porównujemy wyniki i wyłaniamy zwycięzcę. Ale to nie koniec, bo trzeba jeszcze dobrze zinterpretować dane, by wiedzieć, czy zmiany warto wprowadzić na stałe. A gdy któraś wersja pokaże pazury, wdraża się ją na szeroką skalę. Tak właśnie testowanie A/B pomaga uniknąć zgadywania i działa na bazie twardych faktów, poprawiając marketing i doświadczenia użytkowników.

Etapy przeprowadzania testów A/B

Zamiast rzucać się na głęboką wodę, zaczynamy od zimnego prysznica w postaci analizy liczb – kliknięć, czasu na stronie. Dzięki temu wiemy, gdzie leży bolączka. Potem idziemy głębiej, badając, co użytkownicy naprawdę myślą i czują – bo cyfry to nie wszystko. Zebrane dane służą do ustalenia priorytetów i przygotowania kilku wersji strony, które podejmiemy do testów.

Ważne, by wyniki miały solidną podstawę:

- zadbać o statystyczną istotność,

- równomiernie dzielić ruch,

- zbierać dane od wystarczająco dużej grupy.

Dopiero wtedy można z czystym sumieniem wyciągnąć wnioski i zdecydować, które zmiany mają sens.

Podział ruchu i próba badawcza

Wyobraź sobie, że twoi użytkownicy to tłum na koncercie – losowo kierujemy ich pod różne sceny, żeby sprawdzić, która z nich gra lepszą muzykę. Ten losowy i równy podział ruchu to fundament wiarygodnych wyników. Jednak nawet najlepsze próby nie wystarczą, jeśli liczba uczestników jest za mała.

W dodatku test musi trwać wystarczająco długo – najlepiej przez cały tydzień – bo zachowania ludzi zmieniają się jak nastrój na jesiennym spacerze.

Segmentacja danych to trochę jak dzielenie publiki na fanów rocka, popu i jazzu – pozwala zrozumieć, jak różne grupy reagują na zmiany. Bez tego łatwo przegapić, kto naprawdę docenia nowości. Kluczowe jest także monitorowanie, czy różnice są statystycznie istotne – inaczej można się nabrać na przypadkowe fluktuacje i podjąć złą decyzję.

Jak wybrać cele testów A/B?

Wybór celów testów A/B przypomina planowanie wyprawy – zanim wyruszysz, musisz znać teren i przewidzieć przeszkody. Najpierw poznaj swoich użytkowników – co ich kręci, a co zniechęca. Sprawdź, gdzie twoja strona kuleje, korzystając z aktualnych danych. Potem ustal, co chcesz osiągnąć – te cele muszą być jak drogowskazy, które wskażą kierunek.

Często wybierane KPI to:

- liczba konwersji,

- średni czas na stronie,

- współczynnik odrzuceń.

Cel musi być mierzalny i jasny, inaczej łatwo zgubić się w gąszczu danych. Regularne analizowanie wyników pozwala modyfikować kurs i stale podnosić efektywność działań. To jak tuning samochodu – ciągle udoskonalasz, by jechał szybciej i sprawniej.

Identyfikacja problemu i hipoteza testu A/B

Zanim rzucisz się na zmiany, trzeba dobrze zdiagnozować, co naprawdę szwankuje. Tu wchodzą na scenę dane ilościowe – liczba kliknięć, czas odwiedzin – oraz jakościowe obserwacje, które odsłaniają motywy użytkowników. To trochę jak detektyw zbierający dowody.

Na ich podstawie tworzymy hipotezy – np. zmiana koloru przycisku CTA na pomarańczowy może przyciągnąć więcej spojrzeń i kliknięć. Brzmi banalnie? Może, ale właśnie takie małe rzeczy potrafią mieć duży wpływ. Kluczowe jest, by problem i hipoteza były jasno określone – bez tego test to strzał na ślepo.

Priorytetyzacja testów A/B

Zamiast próbować zmieniać wszystko naraz, warto ustalić kolejność – co najpierw, co potem? Metoda priorytetyzacji ocenia problemy pod kątem łatwości wdrożenia i potencjału wpływu na konwersję, w pięciopunktowej skali.

Weźmy za przykład pomysł na zmianę koloru przycisku CTA – szybki, tani i może przynieść sporo zysków, więc często dostanie wysoki priorytet. Natomiast większe zmiany strukturalne strony bywają bardziej skomplikowane i kosztowne, więc trafiają niżej na liście.

Ważne, by decyzje opierać się zarówno na danych liczbowych, jak i jakościowych – w końcu chodzi o to, co przyniesie realny efekt dla użytkowników i biznesu.

Jak długo powinny trwać testy A/B?

Nie ma złotej reguły, ale zwykle tydzień to minimum. Dlaczego? Bo trzeba zebrać wystarczająco dużo danych, żeby nie wyciągać pochopnych wniosków. Ruch na stronie i wskaźnik konwersji to kluczowe czynniki – im więcej odwiedzających, tym krótszy test może być.

Sezonowość zachowań też ma znaczenie – weekend różni się od środy, święta od zwykłego dnia. Dlatego testy trwające pełny tydzień uchwycą te niuanse. Nie warto kończyć testu zaraz po osiągnięciu statystycznej istotności, bo krótkotrwałe trendy mogą zmylić. Lepiej poczekać trochę dłużej, aby upewnić się, że zmiany są trwałe.

Jak analizować wyniki testów A/B?

Analiza wyników to nie luźna rozmowa przy kawie, lecz precyzyjny rytuał. Najpierw sprawdź, czy wszystko działało poprawnie – czy warianty się nie mieszały, czy narzędzia zbierały dane bez zakłóceń. Google Analytics i podobne programy potrafią tu być nieocenione.

Najważniejsze jest skupienie się na celach konwersji – one są jak latarnia morska prowadząca przez chaos danych. Statystyczna istotność to strażnik, który mówi, czy różnice są realne, czy tylko przypadkowe. Dziel dane na segmenty – demografia, zachowania – by zobaczyć, kto najlepiej reaguje na zmiany. To pozwala lepiej dostosować strategię i sprawić, że strona działa jak dobrze naoliwiona maszyna.

Istotność statystyczna i analiza danych

Bez statystycznej istotności testy A/B to trochę jak wróżenie z fusów. Narzędzia analityczne pomagają wyliczyć, ile prób potrzebujesz, by mieć pewność, że wyniki nie są dziełem przypadku. Analiza musi być systematyczna i obejmować każdy etap eksperymentu, bo tylko wtedy można zrozumieć, jak zmiany wpływają na użytkowników. Gdy statystyczna istotność jest potwierdzona, decyzje nabierają mocy i są mniej ryzykowne.

Segmentacja danych i analiza zachowań użytkowników

Podział użytkowników na grupy według demografii czy źródeł ruchu to klucz do odszyfrowania tajemnic ich zachowań. Tak jak różni ludzie lubią różne smaki, tak różne segmenty reagują inaczej na zmiany na stronie. Sprawdzanie współczynnika odrzuceń i innych wskaźników pozwala wychwycić miejsca, gdzie użytkownik się gubi lub rezygnuje. Dzięki temu można wyostrzyć działania optymalizacyjne i zwiększyć konwersję tam, gdzie naprawdę jest to potrzebne.

Jak optymalizować konwersję za pomocą testów A/B?

Optymalizacja to nie sprint, a maraton – wymaga cierpliwości, planu i systematyczności. Testy A/B to narzędzia eksperymentów – zmieniasz kolory, teksty, układ i obserwujesz, co działa lepiej. Jeśli widzisz, że przycisk CTA w innym kolorze przyciąga więcej kliknięć, to znak, że idziesz w dobrą stronę.

Podstawą są hipotezy oparte na danych, nie na przeczuciach. Regularne testy odsłaniają nowe możliwości i pozwalają dostosować stronę do użytkowników, jak krawiec szyjący garnitur na miarę.

Po testach ważne jest, by nie tylko wprowadzić zmiany, ale też obserwować ich efekty w czasie – by nie dać się zwieść chwilowym modom czy przypadkowym wzrostom.

Kilka zasad:

- optymalizacja to ciągły proces,

- eksperymentuj świadomie,

- analizuj wyniki z otwartą głową.

Optymalizacja stron internetowych i UX w e-commerce

W świecie e-commerce doświadczenie użytkownika to król. Nawet najpiękniejsza oferta nie sprzeda się, jeśli strona będzie jak labirynt bez wyjścia. Optymalizacja UX to nie tylko estetyka, ale przede wszystkim funkcjonalność – łatwe nawigowanie, przejrzysty układ i zachęcające przyciski.

Testy A/B to jak laboratorium, w którym sprawdzasz, które zmiany przynoszą najlepsze efekty. Może to być lepsze rozmieszczenie treści, zmiana koloru przycisków czy uproszczenie menu. Efekt? Więcej zakupów i dłuższy czas na stronie, a to przekłada się na realne zyski.

Nie zapominaj o monitoringu po wdrożeniu zmian – to pozwala reagować na zmieniające się potrzeby rynku i ciągle ulepszać witrynę.

Zmiany na stronie i ich efektywność

Każda zmiana na stronie to jak ruch na szachownicy – trzeba ją dobrze przemyśleć i poprzeć solidnymi danymi. Testy A/B pozwalają sprawdzić, które ruchy są skuteczne, a które to tylko pozorny blef. Jeśli na przykład kliknięcia na przycisk CTA są niskie, warto poeksperymentować z kolorami czy tekstem.

Regularne testowanie i analiza to podstawa, by decyzje nie były strzałami w ciemno. Segmentacja użytkowników pomaga zrozumieć, jak różne grupy reagują na zmiany i pozwala lepiej dopasować strategię. Dzięki temu konwersja rośnie, a użytkownicy zostają na dłużej.

Najczęstsze błędy w testach A/B i jak ich unikać

Pułapki czyhają na każdym kroku – zbyt mała próbka, źle dobrana grupa, błędne wnioski. To wszystko może sprawić, że wyniki testów będą jak miraż na pustyni – piękne, ale nieprawdziwe. Dlatego tak ważne jest, by dobrze zaplanować badanie i zadbać o reprezentatywność próby.

Nie mniej niebezpieczne są błędy w interpretacji wyników. Warto korzystać z narzędzi analitycznych i patrzeć na dane w szerszym kontekście. No i absolutnie unikaj wprowadzania kilku zmian na raz – to jak mieszanie kolorów farby bez wzornika, trudno potem powiedzieć, co dało efekt.

Trzymanie się ustalonych procedur i ciągłe monitorowanie postępów to sposób na ograniczenie ryzyka i zwiększenie skuteczności testów.

Błędy w próbkowaniu i interpretacji wyników

Nawet najlepszy plan może się sypać, jeśli próbka jest zbyt mała albo ruch nie jest losowo podzielony. W efekcie dostajesz dane, które są jak obraz odbity w krzywym zwierciadle – zniekształcone i niewiarygodne.

Do tego dochodzi problem błędnej interpretacji – czasem chcemy, żeby wyniki wyglądały dobrze i ignorujemy fakty. Dlatego ważne jest, by nie spieszyć się z decyzjami i korzystać z narzędzi, które pomagają spojrzeć na dane obiektywnie.

Unikaj też robienia kilku zmian na raz – to jak próba jednoczesnego naprawienia silnika i wymiany opon bez wiedzy, która z tych czynności wpłynęła na poprawę.

Redukcja ryzyka i optymalizacja testowania

Systematyczność to najlepszy przyjaciel każdego testera A/B. Dobrze zaplanowany proces pozwala zmniejszyć błędy i zdobyć wyniki, które naprawdę coś znaczą. Regularne audyty i analizy to jak przegląd samochodu przed długą trasą – pozwalają wychwycić usterki i wprowadzić poprawki.

Dzięki temu testy A/B nie są tylko narzędziem do sprawdzenia, co działa, ale również sposobem na ciągłe doskonalenie. Kiedy masz kontrolę nad danymi i procesem, możesz podejmować decyzje oparte na twardych faktach, a nie na przeczuciach.

Kluczem jest czujność – monitoruj podział ruchu, analizuj statystyki i regularnie modyfikuj strategie. W ten sposób unikasz pułapek i maksymalizujesz szanse na sukces.